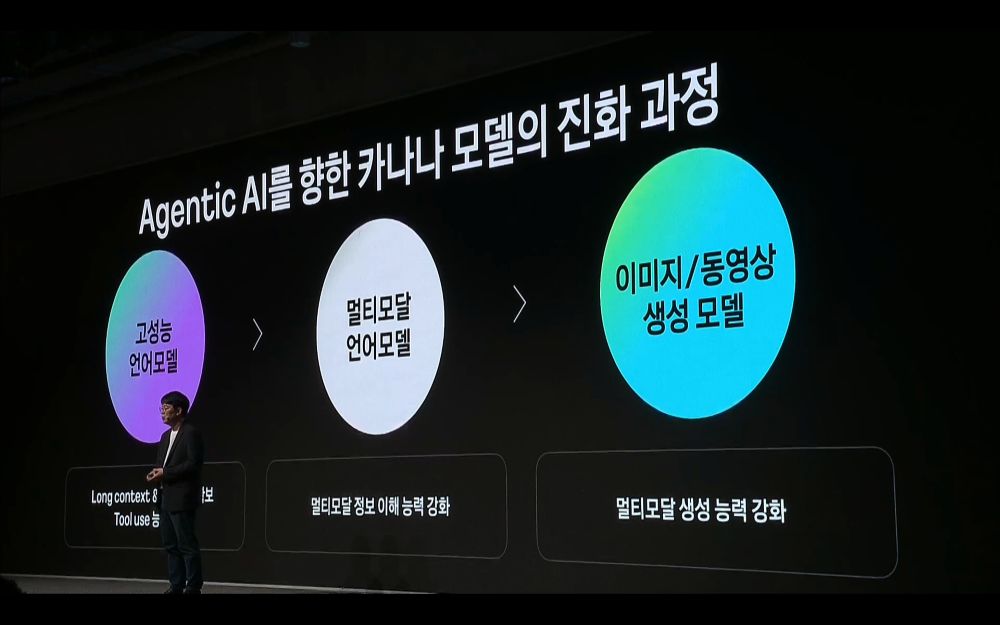

에이전틱 AI 준비하는 카카오, 옴니모달 모델로 나아간다

에이전틱 AI 시대를 앞두고, 카카오가 자체 AI 모델 카나나를 옴니모달 모델로 진화시킨다는 목표를 제시했다. 고성능 LLM에서 보고 들으며 이해하고 말하는 멀티모달, 나아가 이미지와 영상 생성 모델까지의 여정을 공개했다. 카카오는 연말까지 멀티모달 기반 음성모델 지원 언어를 5개 국어까지 확대한다는 계획이다.

24일 경기도 용인시에 위치한 ‘카카오 AI 캠퍼스’에서 열린 개발자 컨퍼런스 ‘이프카카오(IF KAKAO) 2025’에서 카카오 김병학 성과리더는 “진화하는 고성능 모델을 기반으로 사람처럼 어떤 형태의 정보든 이해하고 출력하는 애니투애니(Any to Any) 모델로 나아가겠다”고 했다.

옴니모달 모델이란 고성능 LLM을 기반으로 텍스트, 음성, 이미지, 영상 등 다양한 형태의 정보를 이해하고 생성하는 AI모델을 뜻한다. 김 리더가 말한 애니투애니 모델과 같은 의미다.

김 리더는 에이전틱 AI의 핵심 능력으로 지각, 추론, 행동 3가지를 꼽았다. 고성능 LLM 기반 긴 맥락 처리 멀티모달, 추론능력, 외부 능력 활용능력을 집중 강화할 계획이다.

앞서 카카오는 지난해부터 카나나 언어모델을 꾸준히 소개, 올해 2월에는 언어 모델 라인업을 완성했다. 이후 5월에는 수학, 코딩 등의 고난이도 문제 해결 능력을 향상시킨 Kanana-1.5를, 이후에는 인퍼런스 효율성을 높인 Kanana-1.5를 기반으로 MoE 구조의 모델을 개발했다.

앞서 카카오는 지난해부터 카나나 언어모델을 꾸준히 소개, 올해 2월에는 언어 모델 라인업을 완성했다. 이후 5월에는 수학, 코딩 등의 고난이도 문제 해결 능력을 향상시킨 Kanana-1.5를, 이후에는 인퍼런스 효율성을 높인 Kanana-1.5를 기반으로 MoE 구조의 모델을 개발했다.

장기적으로 지시를 따르는 ‘Instruct’ 모델과 깊게 생각하는 ‘Resoning’ 모델을 통합해 카카오 서비스에 최적화된 하이브리드 언어모델을 완성한다는 계획이다. 김 리더는 “서비스 시 추론 효율성을 강화하고 체감 속도를 높이는 한편, 에이전틱 AI 역량 강화에 집중하려 한다”고 설명했다. 이를 위해서는 복잡한 지시를 잘 따르는 능력과, 외부 도구를 잘 활용하는 능력, 다국어 확장, 환각 없이 사실 기반 답변하는 능력이 필요하다고 덧붙였다.

연내 공개할 Kanana-2.0의 방향성도 공개했다. 김 리더는 “모든 크기 모델에 공통적으로 ‘MLA(Multi-Head Latent Attention)’를 적용했으며, 큰 크기 모델에는 ‘MoE(Mixture of Experts)’를 채택했다”고 설명했다. MLA는 키, 밸류 등을 압축해 효율적으로 처리한다면, MOE는 처리 과정 중 일부 파라미터만 채택해 비용 효율적 구조를 제공한다.

카카오는 두 구조를 이용한 ‘Kanana-2-30b-a3b’ 모델을 개발하고 있다. 김 리더는 프리뷰 단계인 해당 모델에 대해 “Kanana-1.5-32.5b와 비교했을 때 추론처리량이 획기적으로 증가하고 응답속도도 압도적으로 빠르다”며, “동접자가 많은 환경에서도 추론 능력을 높였다”고 말했다.

경량 모델 고도화를 위해 8b 모델도 함께 개발하고 있으며, 온디바이스 모델인 1.3b 모델로도 발전시킬 계획이다. 김 리더는 8b 모델 프리뷰 버전에 대해 “기존 1.5b보다 뛰어난 성능으로, 향후 다양한 규모의 고성능 모델을 구축하는 핵심이 될 것이다”고 말했다.

옴니모달 모델인 ‘Kanana-o-omnimodal ai(이하 Kanana-o)’의 방향성도 소개했다. 김 리더에 따르면 Kanana-o는 국내 최초로 텍스트와 음성, 이미지를 이해하고 텍스트와 음성으로 답하는 모델이다.

김 리더는 “외산 모델과 달리 제주도 사투리처럼 각 지역의 방언, 한국 문화와 장소에 대한 인식도 가능하다”며, “사용자와 대화에서 맥락을 파악해 생생한 감정을 담은 음성으로 몰입감 있는 상호 작용이 가능하며, 스트리밍 기술을 적용해 거의 지연 없는 실시간 대화가 가능하다”고 강조했다.

Kanana-o는 카카오의 비전 모델인 ‘Kanana-V’와 오디오 모델 ‘Kanana-A’를 결합한 모델이다. 검증된 언어모델을 2개의 비전모델과 오디오 모델이 공유하는 구조이기 때문에, 높은 성능을 낼 수 있다는 게 김 리더의 설명이다.

Kanana-V는 다양한 멀티모달 데이터셋과 사람이 선호도 표기한 데이터 집중 학습해 AI가 사용자 의도 더욱 잘 파악하도록 했다. 김 리더는 “(모델 크기는) 3b로, 복잡한 수학 문제 이미지를 올려도 빠르게 풀 수 있는 고성능 모델이다”고 설명했다.

반면 음성 모델인 Kanana-A는 소리 낸 걸 넘어 사용자의 감정 표현에 초점을 맞췄다. 입력된 텍스트를 분석해 적합한 톤으로 말하거나, 사용자가 지정한 음성 스타일을 따라하는 것도 가능하다. 특히 서비스 적용을 고려해, 한국어 데이터셋을 자체 구축해 한국어 능력을 강화했다.

앞으로의 Kanana-o의 고도화를 위해 카카오는 실제 사람들 대화처럼 자연스럽고 흡입감 있는 대화 역량을 키운다는 계획이다.

이를 위해 ▲음성 기반의 멀티턴 대화 처리 능력 ▲사람처럼 끊김없이 소통하는 Full-duplex 음성 대화 지원 ▲인간의 가치에 부합하는 답변을 위한 학습과 안전성 강화를 개발 방향성으로 내세웠다.

또 카카오는 어떤 것이든 자유자재로 이해하고 답하는 옴니모달로 나아가기 위해, 생성하는 능력까지 고도화한다는 목표다. 이를 위해 현재 이미지 생성 모델 ‘Kanana-kollage’를 서비스 내 적용하고 있으며, 동영상 생성 모델인 ‘Kanana-kinema’로 확장하고 있다.

김 리더는 Kanana-kinema에 대해 “단순 이미지 움직이는 것 넘어 인물 포즈를 정교하게 재현하도록 해 자연스러운 인물 영상을 제작하려 한다”며, “대규모 서비스 적용을 고려해 생성 속도를 단축하는 최적화 작업도 진행한다”고 말했다.

멀티모달 기반인 음성 모델의 기능도 보다 강화한다. 지금까지는 한국어와 영어만 지원했다면, 연말까지 중국어와 일본어, 베트남어까지 총 5개 국어로 확대해 글로벌 사용자도 이용할 수 있는 AI를 제공한다는 목표다.

글. 바이라인네트워크

<성아인 기자> aing8@byline.network