구글I/O 2025에서 발표된 개발자 AI 도구 총정리

구글은 20일(현지시간) 미국 마운틴뷰에서 개최한 연례 개발자 컨퍼런스 ‘구글I/O 2025’에서 개발자의 AI 구축을 위한 업데이트를 발표했다.

구글은 제미나이 2.5 플래시 미리보기에서 코딩과 복잡한 추론 작업 성능을 더 높였다고 밝혔다.

사고 요약 기능이 제미나이 2.5 모델군 전반에 적용됐다. 사고 요약 기능은 모델의 추론 과정에서 일어나는 모든 행동을 일목요연하게 정리해 보여주는 기능이다. 개발자는 제미나이2.5의 추론 기능을 사용하면서 발생하는 비용에 더 높은 가시성과 제어 역량을 확보할 수 있다.

스마트폰에서 구동되는 SLM ‘젬마3n’

구글은 소형언어모델(SLM)인 ‘젬마’ 모델군의 새 시리즈를 공개했다.

‘젬마3n(Gemma 3n)’을 공개했다. 젬마3n은 휴대폰, 노트북, 태블릿 등에서 실행될 수 있는 소형 멀티모달 모델이다. 텍스트, 오디오, 이미지, 비디오 등을 모두 지원한다.

젬마3n은 퀄컴, 미디어텍, 삼성 시스템SLI 등과 협력으로 구축됐다.

새 모델은 공유 아키텍처를 기반으로 구축됐다. 차세대 제미나이 나노에도 새로운 공유 아키텍처가 적용될 예정이다.

구글딥마인드의 에이어당 임베딩(PLE, Per-Layer Embeddings)를 활용해 RAM 사용량을 크게 줄였다. 원시 매개변수 수는 5B와 8B다.

젬마3n은 모바일에서 젬마3 4B 대비 약 1.5배 더 빠르게 반응하도록 최적화됐다. PLE, KVC 공유, 고급 활성화 양자화 등의 기능을 제공한다.

MatFormer 학습을 통해 2B 활성 메모리 풋프린트 하위 모델을 기본으로 포함하는 4B 활성 메모리 풋프린트 모델이다. 별도의 모델을 호스팅하지 않고도 성능과 품질을 동적으로 절충할 수 있는 유연성을 제공한다는 설명이다. 4B 모델에서 특정 사용 사례와 관련된 품질 및 지연시간 절충에 최적으로 맞는 하위 모델을 동적으로 생성할 수 있는 ‘믹스앤매치’ 기능을 도입했다.

로컬 실행을 통해 인터넷 연결 없이도 동작하므로, 사용자 개인정보를 보호할 수 있다.

젬마3n은 다양한 미디어를 이해하며, 비디오 이해도가 전작 대비 크게 향상됐다. 오디오 기능을 통해 모델이 고품질 자동음성인식(녹음), 번역(음성 번역 텍스트 변환) 등을 수행할 수 있다. 여러 모드에 걸쳐 복잡한 다중 모드 상호작용을 이해할 수 있도록 지원하게 될 예정이다.

한국어, 일본어, 독일어, 스페인어, 프랑스어 등 다국어 성능이 크게 향상됐다.

젬마3n은 미리보기 버전이며, 구글 AI 스튜디오와 구글 AI 엣지에서 활용 가능하다.

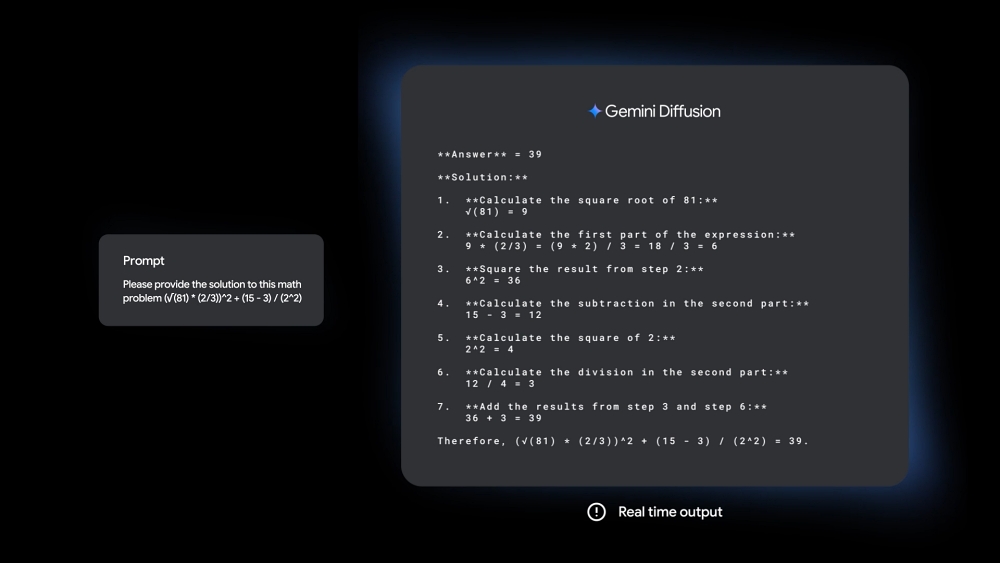

제미나이 디퓨전

구글 딥마인드는 텍스트를 직접 예측하는 대신, 노이즈를 단계적으로 개선해 출력을 생성하는 텍스트 디퓨전 모델인 ‘제미나이 디퓨전’을 발표했다.

제미나이 디퓨전은 빠르게 솔루션 생성을 반복하면서 생성 과정에서 오류를 수정해 최종 결과물을 내놓는다. 이는 수학 및 코드 맥락을 포함해 편집 같은 작업에서 유용하다.

기존 언어모델 방식보다 5배 빠른 속도로 데이터를 생성하면서, 코딩 성능은 그대로 유지할 수 있다고 한다.

구글 측은 그동안 자사의 어떤 모델보다 가장 빠르게 콘텐츠를 생성하며, 토큰 블록 전체를 한번에 생성해 자기 회귀 모델보다 사용자 프롬프트에 더 일관적인 응답을 제공할 수 있다고 강조했다. 또한 더 일관된 출력을 위해 생성 중 발생한 오류를 수정한다고 덧붙였다.

제미나이 디퓨전은 실험 단계로 대기자 명단에 등록해 이용해볼 수 있다.

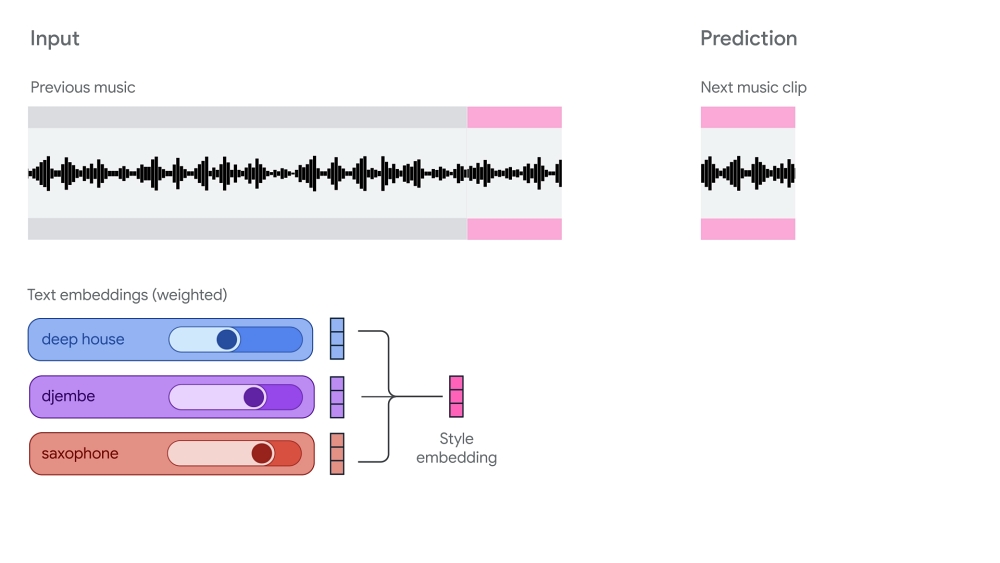

리리아 리얼타임

구글은 실시간으로 상호작용하며 음악을 제작, 제어, 연주할 수 있는 실험적 인터랙티브 음악 생성 모델 ‘리리아 리얼타임(Lyria RealTime)’을 공개했다.

여러 텍스트 프롬프트를 혼합해 장르를 섞고, 악기를 바꾸고, 음악의 분위기를 바꿀 수 있다. 키, 템포, 밀도, 밝기도 직접 조절할 수 있다고 한다. 또한 공연이나 제작에서 활용할 수 있는 전문가급 48kHz 스테레오 오디오를 생성한다.

리리아 리얼타임은 사용자 컨트롤에 반응해 음악 스트림을 생성한다. 밴드 연주자처럼 자체 출력과 사용자 입력을 기반으로 새로운 음악을 연주하는 ‘잼’을 한다는 것이다.

리리아 리얼타임은 제미나이 API를 통해 제공되며, 구글 AI 스튜디오의 시작 앱에서 써볼 수 있다.

젬마 패밀리

구글은 젬마를 의료 전용 모델로 변형한 ‘메드젬마(MedGemma)’와, 수화를 텍스트로 변형하는 ‘사인젬마(SignGemma)’도 공개했다.

메드젬마는 의료 이미지 분석과 의료 애플리케이션을 개발, 적용하도록 설계된 모델이다. 다중 모드 의료 텍스트 및 이미지 이해 역량을 가졌다.

사인젬마는 미국 수화를 영어 구어체 텍스트로 번역해준다. 이 모델을 이용하면 청각 장애인과 난청 사용자를 위한 앱에 AI 기능을 쉽게 통합할 수 있다.

AI 구축 지원 도구

주피터 노트북 호스팅 서비스인 ‘코랩(Colab)’이 에이전트화된 경험을 제공하게 됐다. 코랩에 원하는 것을 입력하면 노트북에서 코랩을 자동 실행하고, 오류를 수정하고, 코드를 변환해 문제 해결을 지원한다.

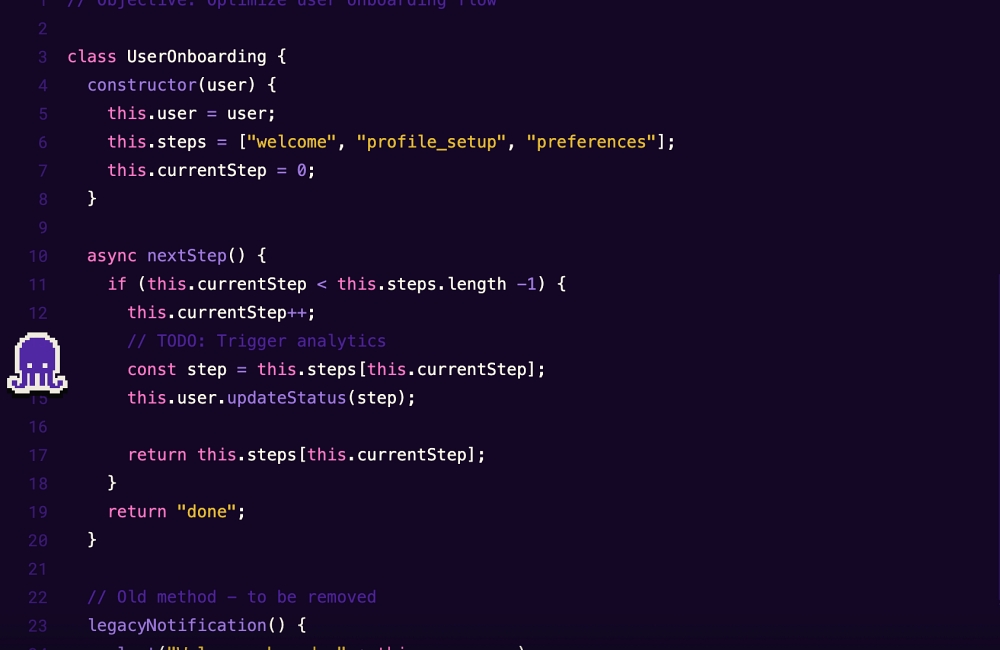

무료 AI 코딩 도우미인 ‘개인용 제미나이 코드 어시스트’와 코드 리뷰 에이전트 ‘제미나이 코드 어시스트 포 깃허브’가 정식 출시됐다. 제미나이2.5가 제미나이 코드 어시스트를 지원하며, 버텍스AI에서 제공되는 제미나이 코드 어시스트 스탠더드 및 엔터프라이즈 등에 200만 토큰 컨텍스트 창이 제공된다.

클라우드 기반 AI 작업 공간인 ‘파이어베이스 스튜디오’도 출시된다. 파이어베이스 스튜디오는 개발자의 아이디어를 풀스택 AI 앱으로 쉽게 구현하도록 지원한다. 개발자는 ‘builder.io’ 플러그인을 사용해 파이어베이스 스튜디오에서 피그마 디자인을 바로 구현할 수 있다. 또한 앱에 백엔드가 필요한 시점을 감지해 자동으로 프로비저닝한다.

구글은 비동기 코딩 에이전트인 ‘줄스(Jules)’를 출시했다. 줄스는 개발자의 불필요한 작업을 대신 처리한다. 버그 백로그 처리, 작업 병렬 처리, 신기능 개발 시작 등을 스스로 수행할 수 있다. 깃허브와 직접 연동해 저장소를 클라우드 VM에 복제하고, 준비 완료되면 프로젝트에 다시 병합할 수 있는 풀리퀘스트를 생성한다.

프론트엔드 디자인을 생성하는 AI 기반 도구 ‘스티치(Stitch)’도 발표됐다. 스티치는 자연어 설명이나 이미지 프롬프트를 사용해 데스크톱과 모바일용 고품질 UI 디자인과 프론트엔드 코드를 생성한다. 대화하면서 디자인을 수정하고, 테마를 조정하며, CSS/HTML이나 피그마로 쉽게 내보내기할 수 있다.

제미나이 API 업데이트

제미나이 API로 개발할 수 있는 개발 플랫폼인 ‘구글 AI 스튜디오’는 제미나이 2.5, 이마젠, 베오 등의 최신 버전을 지원한다. 제미나이2.5 프로를 네이티브 코드 편집기에 통합해 더 빠르게 프로토타입을 제작할 수 있게 됐다. GenAI SDK와 긴밀하게 최적화돼 텍스트, 이미지, 비디오 등의 프롬프트에서 즉시 웹 앱을 생성할 수 있다.

개발자는 라이브 API를 통해 제미나이 2.5 플래시 모델을 이용할 수 있으며, 네이티브 오디오 출력을 이용할 수 있다. 모델이 주요 이벤트를 감지하고 기억할 수 있는 프로액티브 비디오, 모델이 관련없는 오디오 신호에 반응하지 않도록 선택하는 프로액티브 오디오, 모델이 사용자 어조에 반응하는 감성적 대화 등의 기능을 제공한다.

개발자는 제미나이 2.5 플래시와 프로의 텍스트음성변환(TTS) 기능을 미리 사용할 수 있다. 정교한 단일 및 다중 화자 음성 출력을 구현할 수 있다.

비동기 함수 호출도 쓸 수 있게 됐다. 이 기능을 이용하면 대화 흐름을 차단하지 않고 오래 실행되는 함수나 도구를 백그라운드에서 호출할 수 있다.

컴퓨터 사용 API도 이용 가능해졌다. 개발자는 웹브라우징이나 다른 소프트웨어 도구를 사용자 지시에 따라 실행할 수 있는 앱을 개발할 수 있다. 이 기능은 비공개 베타 단계이며 올해말 공개 베타로 전환될 예정이다.

구글은 URL에서 전체 페이지 컨텍스트를 검색하는 ‘URL 컨텍스트’ 지원을 추가했다. 단독으로 사용하거나 구글 검색 같은 도구와 함께 사용할 수 있다.

제미나이 API와 SDK는 모델컨텍스트프로토콜(MCP)를 지원한다.

글. 바이라인네트워크

<김우용 기자>yong2@byline.network