개발자가 주목할 만한 엔비디아 GTC 2025 주요 발표

전세계에서 가장 주목받는 IT 컨퍼런스인 엔비디아의 ‘GTC 2025’가 지난 17일부터 20일까지 열렸다. 차세대 블랙웰 GPU와 슈퍼칩 로드맵, 네트워킹 기술, AI 소프트웨어 등 다양한 발표가 쏟아졌다. 그 가운데 개발자가 주목할 만한 발표를 모아 정리했다.

책상으로 내려온 ‘블랙웰 울트라’

엔비디아는 GTC2025에서 블랙웰의 개선 버전인 블랙웰 울트라 GPU를 선보였다. 블랙웰 울트라는 288GB HBM3e 메모리를 내장했고, 이전세대 대비 50% 향상된 성능을 제공한다. 20페타플롭스 성능을 자랑한다. 추론 중 추가적인 계산을 할당해 정확도를 개선하는 기법인 테스트 타임 스케일링(TTS) 추론과 훈련을 강화한다. 새로 출시되는 데이터센터 시스템은 엔비디아 GB300 NVL72 랙 스케일 솔루션과 엔비디아 HGX B300 NVL16 시스템 등이다. 엔비디아 GB300 NVL72는 엔비디아 GB200 NVL72 대비 1.5배 뛰어난 AI 성능을 제공한다.

엔비디아는 그레이스 블랙웰(GB) 플랫폼을 기반으로 한 엔비디아 DGX 개인용 AI 슈퍼컴퓨터 ‘DGX 스파크(Spark)’와 ‘DGX 스테이션(Station)’을 발표했다.

DGX 스파크(구 프로젝트 디지츠)와 DGX 스테이션은 블랙웰 울트라 플랫폼을 기반으로 한 고성능 그레이스 블랙웰 워크스테이션이다. AI 개발자, 연구자, 데이터 과학자, 학생 등이 데스크톱에서 대규모 모델을 프로토타입 제작, 미세 조정, 추론할 수 있도록 지원한다. 사용자는 이러한 모델을 로컬에서 실행하거나, 엔비디아 DGX 클라우드, 기타 가속 클라우드, 데이터센터 인프라에 배포할 수 있다.

DGX 스파크와 DGX 스테이션은 기존에 데이터센터에서만 사용할 수 있었던 그레이스 블랙웰 아키텍처의 강력한 성능을 데스크톱으로 가져온다. DGX 스파크와 DGX 스테이션은 에이수스, 델테크놀로지스, HP, 레노버 등에서 판매한다.

DGX 스파크는 데스크톱 폼 팩터에 최적화된 엔비디아 GB10 그레이스 블랙웰 슈퍼칩을 탑재한다. GB10은 5세대 텐서 코어와 FP4를 지원하는 강력한 엔비디아 블랙웰 GPU를 탑재해 초당 최대 1000조 회의 연산을 수행할 수 있다. 엔비디아 코스모스 추론(Cosmos Reason) 월드 파운데이션 모델과 엔비디아 GR00T N1 로봇 파운데이션 모델 비롯한 최신 AI 추론 모델을 통해 미세 조정과 추론을 수행할 수 있다.

GB10 슈퍼칩은 엔비디아 NV링크 C2C 상호 연결 기술을 사용해 5세대 PCIe 대비 5배 높은 대역폭을 지원하는 CPU+GPU 코히어런트 메모리 모델을 구현한다. 이를 통해 GPU와 CPU 간 데이터에 액세스해 메모리 집약형 AI 개발자 워크로드 성능을 최적화할 수 있다. DGX 스파크 사용자는 엔비디아의 풀스택 AI 플랫폼을 사용해 코드를 거의 변경하지 않고도 모델을 데스크톱에서 DGX 클라우드 또는 기타 가속화된 클라우드나 데이터센터 인프라로 원활하게 이동할 수 있다.

엔비디아 DGX 스테이션은 AI 개발을 위한 데이터센터 수준의 성능을 구현한다. 엔비디아 GB300 그레이스 블랙웰 울트라 데스크톱 슈퍼칩을 탑재하며, 대규모 훈련과 추론 워크로드 가속화를 위한 784GB의 대용량 코히어런트 메모리 공간을 갖췄다. GB300 데스크톱 슈퍼칩은 최신 세대 텐서 코어와 FP4 정밀도를 갖춘 엔비디아 블랙웰 울트라 GPU를 탑재한다. NV링크-C2C를 통해 고성능 엔비디아 그레이스 CPU에 연결된다.

DGX 스테이션은 또한 하이퍼스케일 AI 컴퓨팅 워크로드를 강화하도록 최적화된 엔비디아 커넥트X8 슈퍼NIC 등을 갖추고 있다. 초당 최대 800기가비트(Gb/s)의 네트워킹을 지원하는 커넥트X-8 슈퍼NIC는 매우 빠르고 효율적인 네트워크 연결을 제공한다.

최첨단 DGX 스테이션 기능과 엔비디아 쿠다-X AI 플랫폼을 결합하면 탁월한 데스크톱 AI 개발 성능을 확보할 수 있다.

AI 추론 서빙 최적화 ‘엔비디아 다이나모’

엔비디아는 오픈소스 추론 소프트웨어인 ‘엔비디아 다이나모(NVIDIA Dynamo)’를 공개했다. AI 팩토리에서 AI 추론 모델을 최저 비용, 최고 효율로 가속하고 확장할 수 있다.

엔비디아 트리톤 추론 서버의 후속 제품인 엔비디아 다이나모는 추론형 AI 모델을 배포하는 AI 팩토리의 토큰 수익 창출을 극대화하도록 고안된 AI 추론 서빙 소프트웨어다. 수천 개의 GPU에서 추론 통신을 조정, 가속한 뒤 분리 서빙 방식을 통해 거대 언어 모델(LLM)의 처리와 생성 단계들을 서로 다른 GPU에 분리한다. 이를 통해 각 단계에서 특정 요구 사항에 맞춰 독립적 최적화가 가능하고, GPU 리소스 활용을 극대화할 수 있다.

엔비디아 다이나모는 추론 성능 개선을 위해 처리량 증가와 비용 절감에 필요한 기능을을 통합했다. 변동성이 심한 요청의 양과 유형에 따라 GPU를 동적으로 추가, 제거, 재할당할 수 있으며, 대형 클러스터에서 특정 GPU를 정확히 찾아내 응답에 필요한 계산과 쿼리 라우팅을 최소화한다. 추론 데이터를 저렴한 메모리나 저장장치로 오프로드하고 필요할 때 신속하게 검색해 추론 비용을 최소화할 수 있다.

엔비디아 다이나모는 추론 시스템이 이전 요청을 처리하면서 메모리에 저장한 지식(KV 캐시)을 잠재적으로 수천 개의 GPU에 매핑한다. 그런 다음 새로운 추론 요청을 가장 적합한 지식이 저장된 GPU로 라우팅해 비용이 많이 드는 재계산을 피하고, 향후 요청에 응답할 GPU도 확보한다.

엔비디아 다이나모 추론 플랫폼은 분리 서빙을 지원한다. 이를 통해 사용자 쿼리 이해를 구축하고 최상의 응답을 생성하는 등 다양한 LLM 계산 단계를 서로 다른 GPU에 할당한다. 분리 서빙을 통해 각 단계의 미세 조정과 리소스 확보를 독립적으로 수행해 처리량을 개선하고 보다 빠른 응답을 제공할 수 있다.

다이나모는 4개의 혁신 구성으로 이같은 기능을 구현한다. ‘GPU 플래너’는 변동성 강한 사용자 수요에 맞춰 GPU를 동적으로 추가하거나 제거해 GPU의 과잉 또는 과소 프로비저닝을 방지하는 계획 엔진이다. ‘스마트 라우터’는 반복되거나 중복되는 요청에 대한 비용이 많이 드는 GPU 재연산 최소화를 위해 대규모 GPU 제품군 전체에 요청을 지시하는 LLM 인식 라우터다. 새로운 수신 요청에 응답할 수 있도록 GPU를 확보한다. ‘로우 레이턴시 커뮤니케이션 라이브러리’는 최첨단 ‘GPU-to-GPU’ 통신을 지원하고 이질적인 장치 간 데이터 교환 복잡성을 줄여 데이터 전송을 가속하는 추론 최적화 라이브러리다. ‘메모리 매니저’는 사용자 경험에 영향을 주지 않으면서 추론 데이터를 저비용 메모리나 저장장치에 지능적으로 오프로드 또는 리로드하는 엔진이다.

다이나모는 같은 수의 GPU를 사용해 엔비디아 호퍼 플랫폼에서 라마 모델을 지원하는 AI 팩토리의 성능과 수익을 2배로 증가시킨다. GB200 NVL72 랙으로 구성된 대형 클러스터에서 딥시크-R1 모델을 구동할 경우, 엔비디아 다이나모의 지능형 추론 최적화를 통해 GPU당 생성되는 토큰의 수가 30배 이상 증가한다.

다이나모는 파이토치, SG랭(SGLang), 텐서RT-LLM, vLLM 등을 지원한다.

엔비디아 다이나모는 엔비디아 NIM 마이크로서비스에서 제공되며, 향후 엔비디아 AI 엔터프라이즈소프트웨어 플랫폼 릴리즈에서 프로덕션급 보안, 지원, 안정성과 함께 지원될 예정이다.

추론 속도 5배, 정확도 20% 높인 ‘라마 네모트론’

엔비디아는 추론 기능을 갖춘 개방형 ‘엔비디아 라마 네모트론(Llama Nemotron)’ 모델 제품군을 발표했다. 개발자와 기업이 비즈니스에 즉시 활용할 수 있는 기반을 제공해 개인 또는 팀으로 복잡한 작업을 해결할 수 있는 고급 AI 에이전트를 구축하도록 지원한다.

라마 모델을 기반으로 구축된 엔비디아 라마 네모트론 추론 제품군은 온디맨드 AI 추론 기능을 제공한다. 엔비디아는 사후 훈련 과정을 통해 이들 제품군을 개선하며 다단계 수학, 코딩, 추론, 복잡한 의사 결정 능력 등을 향상시켰다. 기본 모델에 비해 모델의 정확도를 최대 20%까지 높이고, 다른 주요 개방형 추론 모델에 비해 추론 속도를 5배 최적화한다.

라마 네모트론 모델 제품군은 실제 운영 환경에서 바로 사용할 수 있는 AI 추론을 제공하도록 구축됐다. 나노, 슈퍼, 울트라 등 3가지 크기의 엔비디아 NIM 마이크로서비스로 제공되며, 다양한 배포 요구사항에 각각 최적화됐다.

나노 모델은 PC와 엣지 디바이스에서 최고의 정확도를 제공하고, 슈퍼 모델은 단일 GPU에서 최고의 정확도와 최고의 처리량을 제공한다. 울트라 모델은 다중 GPU 서버에서 작업을 수행할 때 최상의 정확도를 제공할 예정이다.

엔비디아는 네모트론과 다른 개방형 모델에서 생성된 고품질 큐레이션 합성 데이터와 엔비디아가 공동 제작한 추가 큐레이션 데이터 세트를 사용해 엔비디아 DGX 클라우드에서 광범위한 사후 훈련을 수행했다.

모델 개발에 사용된 도구, 데이터 세트, 사후 훈련 최적화 기술은 누구나 사용 가능하다. 개발자는 새로운 엔비디아 에이전틱 AI 도구와 소프트웨어를 사용해 엔비디아 라마 네모트론 추론 모델을 배포함으로써 협업 AI 시스템에서 고급 추론 기능을 쉽게 활용할 수 있다.

엔비디아 AI 엔터프라이즈 소프트웨어 플랫폼은 최신 에이전틱 AI 구축을 지원하는 도구와 기술을 제공한다.

엔비디아 AI-Q 블루프린트는 기업이 자율적으로 인지, 추론, 행동할 수 있는 AI 에이전트에 지식을 연결하도록 지원한다. 엔비디아 NIM 마이크로서비스로 구축된 블루프린트는 멀티모달 정보 검색을 위해 엔비디아 네모 리트리버를 통합하고 오픈 소스 엔비디아 에이전트IQ 툴킷을 사용해 에이전트와 데이터 연결, 최적화, 투명성을 구현한다.

엔비디아 AI 데이터 플랫폼은 AI-Q 블루프린트로 구축된 AI 쿼리 에이전트가 포함된 새로운 유형의 기업 인프라를 위한 맞춤형 참조 설계다. 새로운 엔비디아 NIM 마이크로서비스는 복잡한 에이전틱 AI 애플리케이션을 위한 추론을 최적화해 모든 환경에서 지속적인 학습과 실시간 적응을 가능하게 한다. 엔비디아 네모 마이크로서비스는 AI 에이전트가 인간과 AI가 생성한 피드백을 통해 지속적으로 학습할 수 있는 강력한 데이터 플라이휠을 빠르게 구축, 유지할 수 있는 효율적인 엔터프라이즈급 솔루션을 제공한다. 데이터 플라이휠 구축을 위한 엔비디아 AI 블루프린트는 개발자가 마이크로서비스를 사용해 이 플라이휠을 쉽게 구축하고 최적화할 수 있는 참조 아키텍처를 제공한다.

엔비디아 라마 네모트론 슈퍼 모델과 NIM 마이크로서비스는 build.nvidia.com과 허깅 페이스에서 다운로드할 수 있는 호스트형 애플리케이션 프로그래밍 인터페이스로 제공될 예정이다. 엔비디아 개발자 프로그램 회원은 개발, 테스트, 연구를 위한 목적으로 무료로 이용할 수 있다.

엔비디아 AI-Q 블루프린트는 올해 4월 출시될 예정이며 엔비디아 에이전트IQ 툴킷은 현재 깃허브에서 사용이 가능하다.

가속 아파치 스파크 ‘프로젝트 에테르’

엔비디아는 대규모 GPU 환경에서 아파치 스파크 워크로드를 가속하는 ‘프로젝트 에테르(Project Aether)’를 공개했다. 프로젝트 에테르는 스파크 워크로드를 자동으로 검증, 테스트, 구성, 최적화하는 도구와 프로세스 모음이다. 이를 통해 엔비디아 가속 스파크(Spark) 기능 활용을 극대화할 수 있다.

아파치 스파크는 방대한 데이터 세트를 분석하는데 활용되는 데이터 처리 기술로, 많은 기업이 아파치 스파크용 엔비디아 래피즈 액셀러레이터를 채택하고 있다. 이 오픈 소스 소프트웨어는 엔비디아 가속 컴퓨팅 플랫폼 기반으로 실행돼 코드 변경 없이 엔드투엔드 데이터 사이언스와 분석 처리 과정 속도를 크게 향상시킨다.

프로덕션에서 스파크를 사용할 때 수만개의 복잡한 작업을 관리해야 한다. CPU 전용 컴퓨팅을 GPU 기반 컴퓨팅으로 이전할 때 수작업으로 진행해야 하는 시간 소모가 큰 과정이 될 수 있다.

프로젝트 에테르는 CPU 컴퓨팅을 GPU 기반 컴퓨팅으로 이전할 때 수작업으로 수행했던 수많은 단계를 자동화한다. 모든 스파크 작업을 분석해 GPU 가속에 가장 적합한 후보를 식별하고, 각 작업의 테스트 실행을 준비하고 수행하는 과정이 포함된다. AI를 사용해 각 작업의 구성을 미세 조정함으로써 최대 성능을 구현한다.

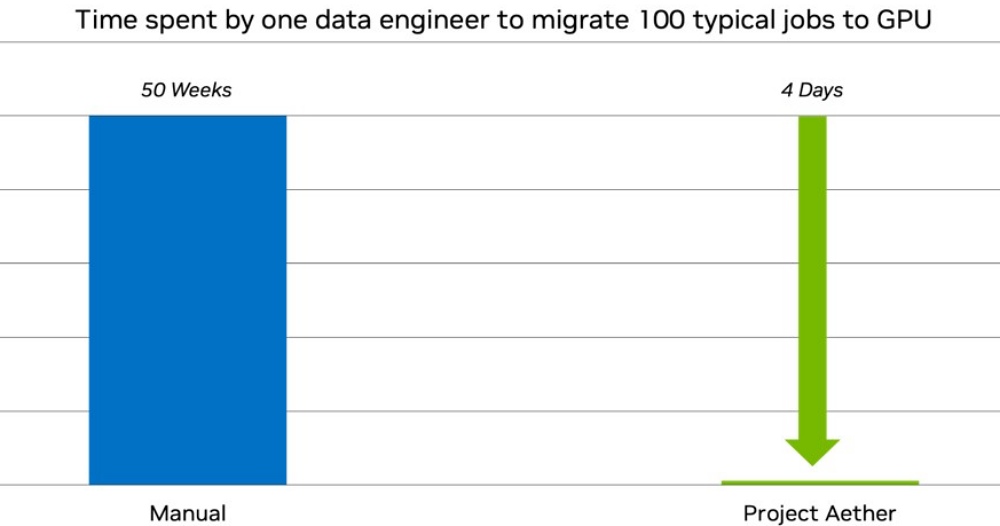

엔비디아에 따르면, 100개의 스파크 작업을 처리해야 하는 기업이 프로젝트 에테르를 사용하면 모든 작업을 엔비디아 GPU 가속에 맞게 구성하고 최적화하는 데 4일밖에 걸리지 않는다. 데이터 엔지니어 한 명이 동일한 프로세스를 수작업으로 수행하면 최대 1년이 걸린다.

물리 AI 개발의 기반 ‘코스모스 월드파운데이션모델’

엔비디아는 올해 ‘엔비디아 코스모스 월드파운데이션모델(WFM)’을 발표했다. 이는 물리 AI 개발을 위해 개방적이고 완전히 맞춤화 가능한 추론 모델을 도입해 개발자에게 월드 생성에 대한 높은 수준의 제어를 제공한다.

코스모스 트랜스퍼 WFM은 세분화 맵(segmentation map), 뎁스 맵(depth map), 라이더 스캔(lidar scan), 포즈 추정 맵(pose estimation map), 궤적 맵(trajectory map) 등 구조화된 비디오 입력을 활용해 제어 가능한 사실적인 비디오 출력을 생성한다.

코스모스 트랜스퍼는 지각 AI 훈련을 간소화한다. 이를 통해 옴니버스에서 생성된 3D 시뮬레이션 또는 실측 정보를 사실적인 비디오로 변환해 제어 가능한 대규모 합성 데이터를 생성한다.

자율주행차 시뮬레이션을 위한 엔비디아 옴니버스 블루프린트는 코스모스 트랜스퍼를 통해 물리 기반 센서 데이터의 변형을 증폭시킨다. 포어텔릭스는 이 블루프린트를 활용해 다양한 주행 데이터 세트에 날씨, 조명 등 조건을 변경해 행동 시나리오를 발전시킬 수 있다. 합성 조작 모션 생성을 위한 엔비디아 GR00T 블루프린트는 옴니버스와 코스모스 트랜스퍼를 결합해 다양한 데이터 세트를 대규모로 생성한다. 오픈USD 기반 시뮬레이션의 이점을 활용해 여러 날이 걸리는 데이터 수집과 증강 시간을 단 몇 시간으로 단축한다.

지난 1월 CES에서 발표된 코스모스 프리딕트 WFM은 텍스트, 이미지, 동영상과 같은 멀티모달 입력으로부터 가상 월드 상태를 생성한다. 새로운 코스모스 프리딕트 모델들은 멀티 프레임 생성(MFG)을 지원해, 시작과 종료 입력 이미지가 주어지면 중간 동작이나 모션 궤적을 예측할 수 있다. 사후 훈련을 위해 특별히 제작된 이들 모델은 오픈 소스로 사용 가능한 엔비디아의 물리 AI 데이터 세트를 통해 맞춤화할 수 있다.

개발자는 엔비디아 그레이스 블랙웰 NVL72 시스템의 추론 컴퓨팅 성능과 대규모 엔비디아 NV링크 도메인을 통해 월드 생성을 실시간으로 구현할 수 있다.

코스모스 리즌(Reason)은 시공간 인식 기능을 갖춘, 개방적이며 완전히 맞춤화 가능한 WFM이다. 연쇄 추론을 사용해 영상 데이터를 이해하고, 사람이 횡단보도에 들어서거나 선반에서 상자가 떨어지는 것과 같은 상호작용의 결과를 자연어로 예측한다.

개발자는 코스모스 리즌을 사용해 물리 AI 데이터 주석과 큐레이션을 개선하고, 기존 WFM을 발전시키거나 새로운 비전 언어 행동 모델을 생성할 수 있다. 코스모스 리즌을 사후 훈련시켜 물리 AI가 특정 작업을 완료하기 위해 무엇을 해야 하는지 지시하는 고급 플래너를 만들 수도 있다.

개발자는 다운스트림 작업에 맞춰, 네이티브 파이토치(PyTorch) 스크립트 또는 엔비디아 DGX 클라우드의 엔비디아 네모 프레임워크를 사용해 코스모스 WFM을 사후 훈련시킬 수 있다.

코스모스 개발자는 가속화된 데이터 처리와 큐레이션을 위해 DGX 클라우드의 엔비디아 네모 큐레이터를 사용할 수 있다.

엔비디아는 신뢰할 수 있는 AI 원칙에 따라 모든 코스모스 WFM에 개방형 가드레일을 적용하고 있다. 엔비디아는 구글 딥마인드와 협업으로 신스ID(SynthID) 기술을 통합해, build.nvidia.com에서 제공되는 코스모스 WFM 엔비디아 NIM 마이크로서비스에서 AI로 생성된 결과물에 워터마크를 추가하고 식별하는 데 도움을 주고 있다.

코스모스 WFM은 엔비디아 API 카탈로그에서 미리보기로 제공되며, 현재 구글 클라우드의 버텍스 AI 모델 가든에도 수록돼 있다. 코스모스 프리딕트와 코스모스 트랜스퍼는 허깅 페이스와 깃허브에서 누구나 사용할 수 있으며, 코스모스 리즌은 얼리 액세스로 제공된다.

엔비디아 엔터프라이즈 AI 소프트웨어와 오라클 통합

엔비디아는 오라클과 함께 자사의 가속 컴퓨팅과 추론 소프트웨어를 오라클의 AI 인프라와 생성형 AI 서비스에 통합한다고 발표했다.

오라클 클라우드 인프라스트럭처(OCI)와 엔비디아 AI 엔터프라이즈 소프트웨어 플랫폼 간 통합은 160개 이상의 AI 도구와 100개 이상의 엔비디아 NIM 마이크로서비스를 OCI 콘솔에서 직접 활용할 수 있게 한다. 양사는 오라클과 엔비디아 AI 블루프린트의 노코드 배포를 지원하고, 엔비디아 cuVS 라이브러리를 활용해 오라클 데이터베이스 23ai에서 AI 벡터 검색을 가속할 예정이다.

OCI 베어메탈 인스턴스와 OCI 쿠버네티스 엔진을 사용하는 쿠버네티스 클러스터에서 엔비디아 AI 엔터프라이즈를 배포 이미지로 사용할 수 있으며, OCI 콘솔 고객은 오라클을 통해 직접 결제하고 고객 지원을 받을 수 있다.

OCI AI 블루프린트는 고객이 소프트웨어 스택을 결정하거나 인프라를 수동으로 프로비저닝할 필요 없이 AI 워크로드를 신속하게 실행할 수 있도록 지원하는 노코드 배포 레시피를 제공한다. 이 블루프린트는 엔비디아 GPU, NIM 마이크로서비스, 사전 구성된 가시성 도구에 대한 명확한 하드웨어 권장 사항을 제공해 기업이 AI 프로젝트를 몇 주에서 몇 분으로 단축할 수 있도록 돕는다.

엔비디아 블루프린트는 엔비디아 스택 전반에 걸친 통합된 개발자 경험을 제공하며, 엔터프라이즈 AI 활용 사례를 위한 참조 워크플로우를 지원한다. 엔비디아 블루프린트를 통해 기업은 엔비디아 AI 엔터프라이즈와 엔비디아 옴니버스, 소프트웨어, API, 마이크로서비스를 사용해 맞춤형 AI 애플리케이션을 구축하고 운영할 수 있다. 예를 들어, 개발자는 고객 서비스 AI 어시스턴트용 엔비디아 AI 블루프린트로 시작한 후, 필요에 따라 맞춤화할 수 있다.

물리적 AI와 시뮬레이션 애플리케이션의 개발, 배포, 확장을 간소화하기 위해, 엔비디아 옴니버스 플랫폼이 올해 말 OCI 마켓플레이스에서 제공될 예정이며, 엔비디아 L40S GPU로 가속된 컴퓨팅 베어메탈 인스턴스가 사전 구성된다.

데이터 과학자는 OCI 데이터 사이언스에서 사전 최적화된 엔비디아 NIM 마이크로서비스를 직접 활용할 수 있다. 데이터 보안과 규정 준수를 위해 모델은 고객의 OCI 테넌시 내에서 실행된다. 고객은 유연한 종량제 기반의 시간 요금제를 통해 모델을 구매하거나, 오라클 유니버설 크레딧을 적용할 수 있다.

오라클과 엔비디아는 오라클 데이터베이스 23ai에서 AI 벡터 검색 워크로드의 벡터 임베딩과 벡터 인덱스 생성 속도를 가속화하기 위해, 엔비디아 GPU와 엔비디아 cuVS를 활용하기 위해 협력하고 있다. 기업들은 텍스트, 이미지, 비디오 등 대량의 입력 데이터를 일괄 벡터화해 벡터 임베딩을 활성화할 수 있으며, 벡터 인덱스를 빠르게 생성하고 유지할 수 있다. 오라클 데이터베이스 고객들은 엔비디아 GPU로 가속화된 AI 벡터 검색을 활용해 AI 파이프라인 성능을 대폭 향상시켜 대규모 AI 벡터 워크로드를 지원할 수 있다.

글. 바이라인네트워크

<김우용 기자>yong2@byline.network