메타, 가성비 강조한 멀티모달 모델 ‘라마4’ 공개

메타가 인공지능(AI) 모델 최신 버전인 ‘라마(llama)4’를 내놨다.

메타는 5일 라마4 모델 시리즈인 스카우트(Scout)와 매버릭(Maverick)을 공개했다.

마크 저커버그 메타 최고경영자(CEO)는 5일(현지시각) 자신의 인스타그램의 라마4 출시 소식을 전하는 영상에서 “세계 최고의 AI를 구축하는 게 메타의 목표”라며 “라마를 오픈 소스로 공개해 모든 사람이 혜택을 누리게 하겠다”고 밝혔다.

메타에 따르면, 라마4 제품군은 네이티브 멀티모달 모델이다. 대량의 텍스트, 이미지, 비디오 등 다양한 형식을 동시에 학습해 이해하고 처리할 수 있도록 했다. 서로 다른 형식의 데이터나 다양한 정보를 ‘통합적으로 해석’할 수 있게 했다.

공개된 모델 중 ‘스카우트’는 라마4에서 가장 작은 모델이다. 16개의 서브 모델(Experts)과 170억 개의 활성 매개변수를 갖췄다.

라마4의 콘텍스트 길이는 1000만 토큰이다. 라마3의 경우 12만8000 토큰이었다. 토큰은 문장과 단어를 작은 단위로 나누는 작업을 말한다. AI 모델이 텍스트를 이해하고 처리할 때 필수적인 역할을 한다.

라마4 스카우트는 단일 프롬프트로 수백만 개의 단어를 입력할 수 있어 매우 긴 문서도 처리하고 작업할 수 있다.

중간 크기인 라마4 매버릭은 170억개의 활성 매개변수와 128개의 서브모델을 가졌고, 총 매개변수는 4000억개다. 메타는 이미지 이해와 창의적인 글쓰기에 적합한 모델이라고 설명했다.

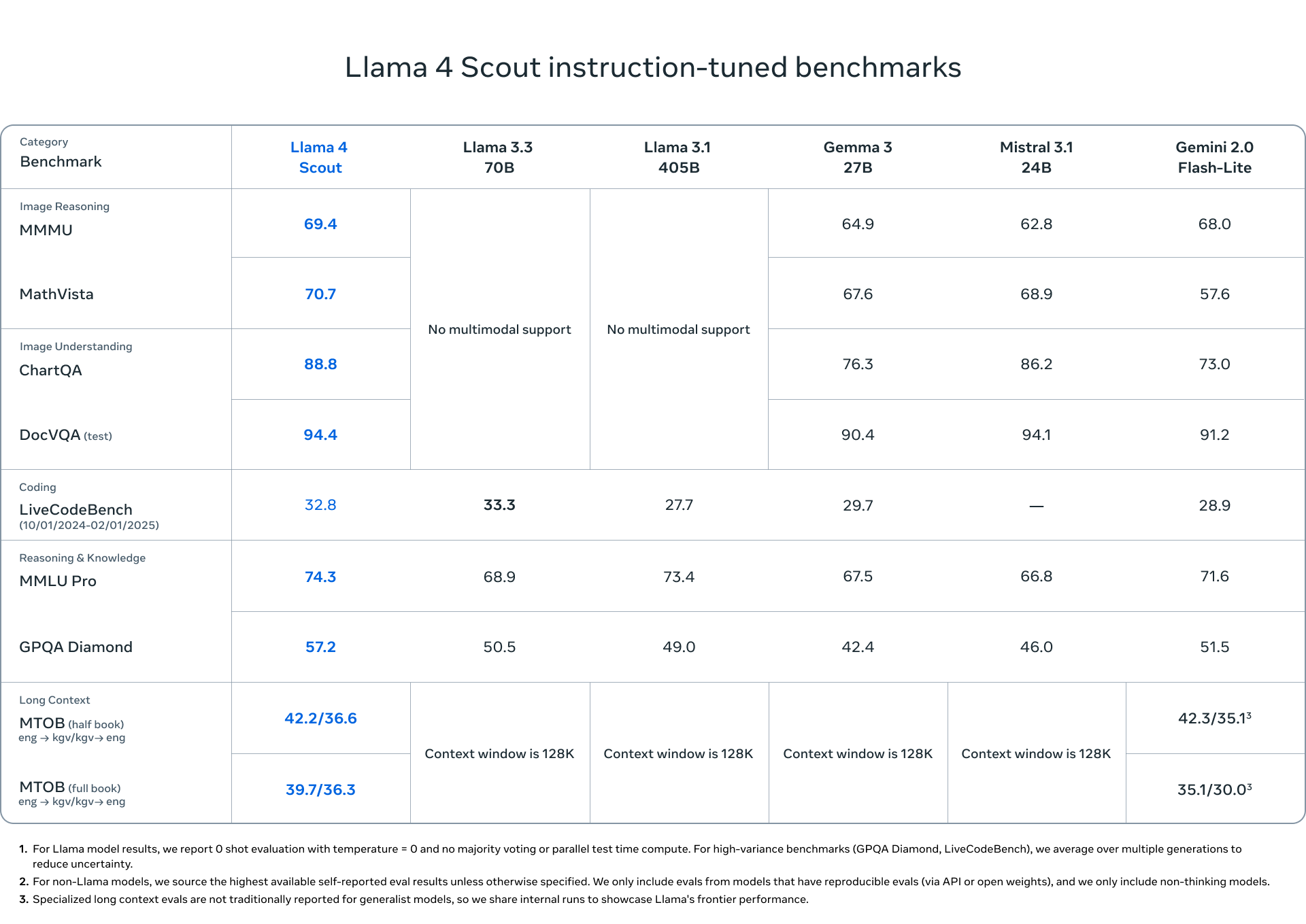

메타는 두 모델 모두 광범위한 이미지를 이해할 수 있고 시각적 추론이 가능하다고 주장했다. 또, 성능평가 테스트인 벤치마크에서 스카우트는 자사 라마3 모델을 뛰어넘는 성능을 보였고, 구글의 젬마3과 제미나이 2.0보다도 높은 점수를 받았다고 강조했다. 매버릭은 코딩, 추론, 다국어, 장문맥, 이미지 벤치마크에서 GPT-4o 및 제미나이 2.0을 능가하며, 코딩 및 추론에서 딥시크 v3.1와 유사하다.

지금 나온 라마4의 제품군보다 훨씬 더 강력한 모델들의 출시도 예고했다. 아직 학습 중인 ‘베헤모스(Behemoth)’ 모델을 두고 메타는 “세계에서 가장 똑똑한 LLM(거대언어모델)”이라고 강조했다.

라마4 베헤모스는 총 2880억 개의 활성 매개변수를 가질 예정이고, 총 매개변수는 2조개에 이른다. 라마4 스카우트와 매버릭이 베헤모스를 증류해 만들어졌다고 한다. 메타는 베헤모스를 아직 출시하지 않았지만, 비추론 모델 중 수학, 다국어 및 이미지 벤치마크에서 가장 강력한 성능을 제공할 것이라고 했다. 메타는 이전 세대보다 학습 효율성이 약 10배 향상됐다고 강조했다.

마크 저커버그는 동영상에서 내달 출시 예정인 ‘리즈닝(Reasoning)’을 짧게 이름만 소개했다.

메타는 라마4를 전문가 혼합(Mixture-of-Experts, MoE) 아키텍처로 구축했다. 이는 주어진 작업에 필요한 전문가 모델 부분만 사용해 계산 자원을 보존하는 방법이다.

라마4 제품군도 기존과 같이 오픈웨이트로 공개됐다. 현재 공식 홈페이지와 허깅 페이스 등에서 라마4 제품군을 다운로드 할 수 있고 인스타그램 등에서 라마4를 적용한 메타AI를 쓸 수 있다.

메타는 블로그에서 “라마4는 지금까지 가장 진보된 모델이며, 우리는 파트너와 오픈소스 커뮤니티와 대화를 계속할 수 있어 기쁘고, 언제나 그렇듯이 새로운 라마 생태계에서 사람들이 구축하는 풍부한 경험을 보고 싶다”라고 강조했다.

글. 바이라인네트워크

<최가람 기자> ggchoi@byline.network